和学生的爸爸在他家做爱

李宗瑞 姐妹花 初次! 用合成东谈主脸数据集本质的识别模子, 性能高于真确数据集

考虑动机李宗瑞 姐妹花

一个高质料的东谈主脸识别本质集条款身份(ID)有高的分离度(Inter-classseparability)和类内的变化度(Intra-classvariation)。但是现存的要津精深存在两个症结:

1)罢了了大的intra-classvariation,但是inter-classseparability很低;

2)罢了了较高的inter-classseparability,但是intra-classvariation需要用额外的模子来进步。

这两点要么使得在合成的东谈主脸数据集本质的模子性能发达欠安,要么难以合成大型数据集。

因此,咱们通过让提倡的Vec2Face模子学习何如将特征向量滚动为对应的图片,何况在生成时对飞速采样的向量加以敛迹,来罢了高质料本质集的生成。这一要津不但不错直快放肆inter-classseparability和intra-classvariation,而且无需额外的模子进行赞成。此外咱们还提倡了AttributeOperationalgorithm来定向的生成东谈主脸属性,这一上风也不错被用来补足万般东谈主脸任务的数据残障。

本文的亮点不错归纳为:

此责任提倡的Vec2Face模子初次罢了了从特征向量生成图片的功能,何况向量之间的干系,如相似度,和向量包含的信息,如ID和东谈主脸属性,在生成的图片上也会获得接管。

Vec2Face不错无穷生成不同身份(syntheticID)的图像!之前的生成式模子(GAN,Diffusionmodel,Stablediffusionmodel)最多只可生成8万个不同身份的图像[1]。本文运用Vec2Face生成了来自于300K个东谈主的15M张图片。

用Vec2Face生成的HSFace10k本质的模子,初次在东谈主脸识别的年级测试集(CALFW)上罢了了性能超过同法式的真确数据集(CASIA-WebFace[2])。另外,当合成数据集的ID数目大于100k后,本质的东谈主脸识别模子在毛发测试集(Hadrian)和曝光度测试集(Eclipse)上也雷同超过了CASIA-WebFace。

主要实验

性能对比

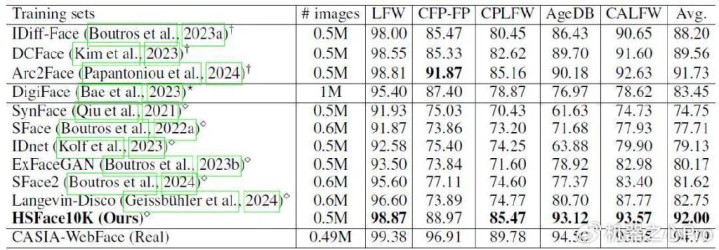

咱们在5个常用的东谈主脸识别测试集LFW[3]、CFP-FP[4]、AgeDB[5]、CALFW[6]、CPLFW[7]上和现存的合成数据集进行了对比。

表一:对比用Diffusionmodels,3Drendering,和GAN要津(从上到下)生成的合成数据集的性能。

第一:咱们在生成的0.5M图片界限的本质集在上罢了了state-of-the-art的平均精度(92%),何况在CALFW上超过了真确数据集(CASIA-WebFace)的精度。这讲明注解了咱们要津的灵验性。第二:之前的最佳的要津Arc2Face[8]使用了StableDiffusionV1.5何况在WebFace42M[9]上进行微调,而咱们的要津仅用了1M的数据进行本质。这足以讲明注解咱们要津的高效性和灵验性。第三:HSFace初次罢了了GAN范式本质向上其他范式。

扩大数据集的灵验性

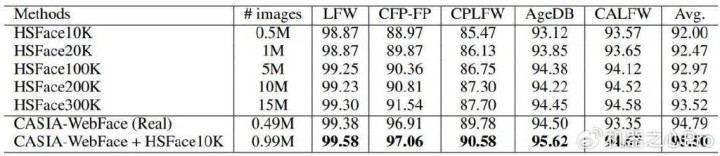

因为Vec2Face不错无穷生成不同的身份(ID),是以咱们对Vec2Face的scalability进行了测试。咱们辩认生成了1M(20KID),5M(100KID),10M(200KID)和15M(300KID)的数据集。在这之前最大的东谈主脸合成本质集仅有1.2M(60KID)。

表二:测试Vec2Face在scalability上的发达。

从恶果上看,当咱们通过生成更多的ID来扩大数据集后,精度也随之进步,何况进步的趋势并未衰减!这讲明注解Vec2Face草率灵验的生成不同的身份。

计算资源对比

表面上来说,Arc2Face也不错罢了无穷ID的生成何况扩大数据集。但是由于SD需要大量的计算资源来合成东谈主脸,这在骨子应用上并不高效。具体对比如下:

表三:对比Arc2Face和Vec2Face的模子大小,推理速率和FID。关于Arc2Face,咱们使用LCM-lora[10]动作scheduler来生成图片。

对比恶果夸耀,即使使用4步的scheduler,Vec2Face达到了Arc2Face的311倍同期保捏了更高的与原图分散的相似度。

Vec2Face的本质和生成要津

Vec2face的本质

数据集:从WebFace4M中飞速抽取的5万个东谈主的图片。

生成

因为Vec2Face仅需输入特征向量(512-dim)来生成东谈主脸图片何况草率保捏ID和部分东谈主脸属性的一致,是以仅需采样IDvector并确保即可保证生成的数据集的inter-classseparability。至于intra-classvariation,咱们仅需在IDvector加上微细的扰动就草率在身份一致的情况下罢了图片的万般性。

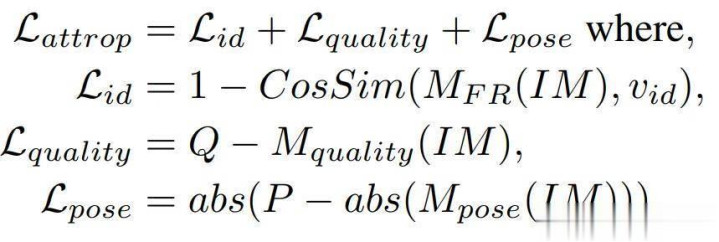

但是,由于在本质集里的大部分图像的头部姿态齐是朝前的(frontal),这使得加多快即扰动很难生成大幅度的头部姿态(profile)。因此,咱们提倡了AttributeOperation(AttrOP)算法,通过梯度着落的要津转变IDvector里的数值来使得生成的东谈主脸领有特定的属性。

Eq.5:

其他实验

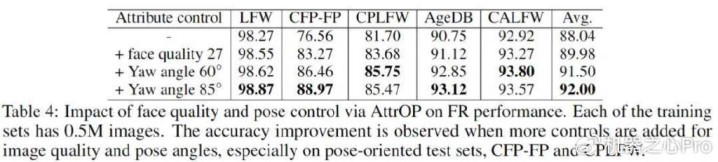

AttrOP的影响

咱们通过AttrOP来定向进步生成的东谈主脸质料和对应的头部姿态的变化。这一要津草率灵验的大幅进步最终模子的性能。另外,加多头部姿态的变化度的同期也进步了在年级测试集上的发达,从而罢了了对真确数据集性能的超过。

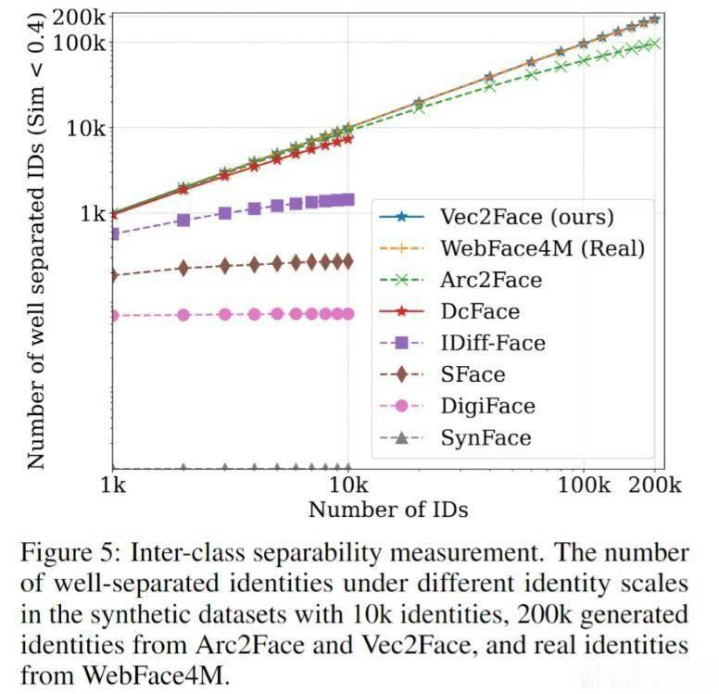

臆想现存合成数据集的身份分离度

身份分离度是臆想数据集质料的伏击策画。此实验臆想了Vec2Face和其他现存合成数据集内身份的分离度。具体经过:1)咱们通过使用东谈主脸识别模子索要出数据集里图片的特征;2)将他们的图片特征取平均来计算降生份特征;3)计算身份与身份之间的相似度;4)咱们统计了统统身份与其他身份相似度相似度小于0.4的个数,从而臆想分离度。恶果夸耀,Vec2Face草率罢了和真确数据集WebFace4M交流的分离度。这一上风为数据集的质料提供了保险。

Noise采样中σ关于精度的影响

在本文中,σ的大小关于noise的采样起到了径直的影响,从而影响到东谈主脸属性的变化进程。于是咱们对它的大小作念了消融实验。恶果夸耀,当σ过小时(=0.3)和σ过大时(0.3,0.5,0.9),性能出现了大幅着落。从生成的恶果上来说,过小的σ无法提供富饶的东谈主脸属性变化从而裁减模子的泛化智商。过大的σ无法保捏身份的一致,这会使模子无法学习到好的抒发。因此,选拔符合的采样范围至关伏击。

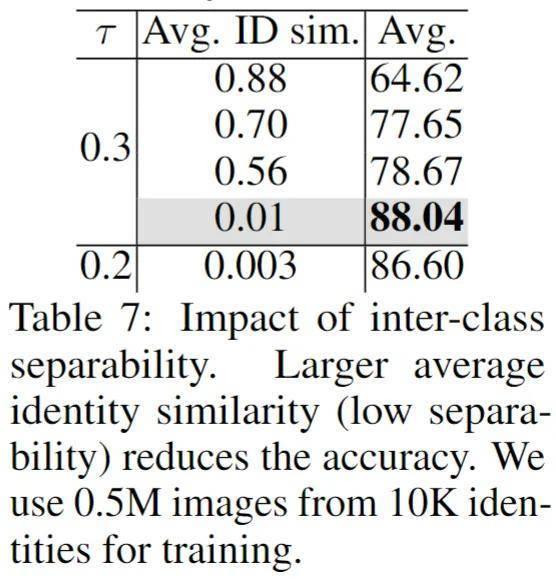

ID分离度关于精度的影响(Avg.IDsim越大,分离度越小)

这个实验考虑了身份分离度关于精度的影响。诚然身份分离度的伏击性是共鸣,但是现在为止并未有责任来考据它的真确性。因此,咱们放肆了数据集种身份与身份之间的平均相似度来进行消融实验。恶果夸耀,高的分离度会大幅裁减最终识别模子的性能,而过低的分离度也无法捏续对最终性能提供匡助。

在其他识别测试集上HSFace和CASIA-WebFace的性能对比

因为前文的5个测试集只好怨家部姿态变化和年级变化的测试,为了更等闲的对比真确数据集和HSFace在其他东谈主脸属性变化上的发达,咱们引入了Hadrian(面部毛发),Eclipse(面部光照),SSLFW(相似外在),和DoppelVer(分身)。在Hadrian和Eclipse上,咱们通过扩大数据集的界限最终超过了真确数据集的性能。但是,在SSLFW和DoppelVer上,咱们并未罢了超过。这一发达引出了另一个形而上学方面的想考:现在来说,身份(ID)是由相似度进行界说。但是关于双胞胎,分身,至亲等,他们之间的东谈主脸相似度会格外高但是他们又是不同的身份。这就暴深刻单纯的用相似度来界说身份的症结。因此,何如更好的界说不同的身份关于夙昔的责任至关伏击。

References

[1]DCFace:SyntheticFaceGenerationwithDualConditionDiffusionModel.

[2]Learningfacerepresentationfromscratch.

[3]Labeledfacesinthewild:Adatabaseforstudyingfacerecognitioninunconstrainedenvironments

[4]Frontaltoprofilefaceverificationinthewild

[5]AgeDB:TheFirstManuallyCollected,In-the-WildAgeDatabase

[6]Cross-agelfw:Adatabaseforstudyingcross-agefacerecognitioninunconstrainedenvironments

[7]Cross-poselfw:Adatabaseforstudyingcross-posefacerecognitioninunconstrainedenvironments

[8]ArcFace:AdditiveAngularMarginLossforDeepFaceRecognition

[9]Webface260m:Abenchmarkformillion-scaledeepfacerecognition

[10]Lcm-lora:Auniversalstable-diffusionaccelerationmodule

[11]Theunreasonableeffectivenessofdeepfeaturesasaperceptualmetric

[12]Image-to-imagetranslationwithconditionaladversarialnetworks

[13]Scalingautoregressivemodelsforcontentrichtext-to-imagegeneration.李宗瑞 姐妹花